fastdfs服务器搭建与维护

一、fastdfs介绍

FastDFS是一款类Google FS的开源分布式文件系统,它用纯C语言实现,支持Linux、FreeBSD、AIX等UNIX系统。它只能通过 专有API对文件进行存取访问,不支持POSIX接口方式,不能mount使用。准确地讲,Google FS以及FastDFS、mogileFS、 HDFS、TFS等类Google FS都不是系统级的分布式文件系统,而是应用级的分布式文件存储服务。

FastDFS 是一个开源的高性能分布式文件系统(DFS)。 它的主要功能包括:文件存储,文件同步和文件访问,以及高容量和负载平衡。主要解决了海量数据存储问题,特别适合以中小文件(建议范围:4KB < file_size <500MB)为载体的在线服务。

二、架构

FastDFS架构包括 Tracker server和Storage server。客户端请求Tracker server进行文件上传、下载,通过Trackerserver调度最终由Storage server完成文件上传和下载。

FastDFS 系统有三个角色:跟踪服务器(Tracker Server)、存储服务器(Storage Server)和客户端(Client)。

Tracker Server:跟踪服务器,主要做调度工作,起到均衡的作用;负责管理所有的 storage server和 group,每个 storage 在启动后会连接 Tracker,告知自己所属 group 等信息,并保持周期性心跳。通过Trackerserver在文件上传时可以根据一些策略找到Storageserver提供文件上传服务。

Storage Server:存储服务器,主要提供容量和备份服务;以 group 为单位,每个 group 内可以有多台 storage server,数据互为备份。Storage server没有实现自己的文件系统而是利用操作系统 的文件系统来管理文件。

Client:客户端,上传下载数据的服务器,也就是我们自己的项目所部署在的服务器。

架构如下:

1、Tracker 集群:

FastDFS集群中的Tracker server可以有多台,Trackerserver之间是相互平等关系同时提供服务,Trackerserver不存在单点故障。客户端请求Trackerserver采用轮询方式,如果请求的tracker无法提供服务则换另一个tracker。

2、Storage 集群

为了支持大容量,存储节点(服务器)采用了分卷(或分组)的组织方式。存储系统由一个或多个卷组成,卷与卷之间的文件是相互独立的,所有卷的文件容量累加就是整个存储系统中的文件容量。 一个卷由一台或多台存储服务器组成,卷内的Storage server之间是平等关系,不同卷的Storageserver之间不会相互通信,同卷内的Storageserver之间会相互连接进行文件同步,从而保证同组内每个storage上的文件完全一致的。 一个卷的存储容量为该组内存储服务器容量最小的那个(因为每个storageserver文件一致,最小存储的服务器已达上限),由此可见组内存储服务器的软硬件配置最好是一致的, 卷中的多台存储服务器起到了冗余备份和负载均衡的作用。

在卷中增加服务器时,同步已有的文件由系统自动完成,同步完成后,系统自动将新增服务器切换到线上提供服务。当存储空间不足或即将耗尽时,可以动态添加卷。只需要增加一台或多台服务器,并将它们配置为一个新的卷,这样就扩大了存储系统的容量。

采用分组存储方式的好处是灵活、可控性较强。比如上传文件时,可以由客户端直接指定上传到的组也可以由tracker进行调度选择。一个分组的存储服务器访问压力较大时,可以在该组增加存储服务器来扩充服务能力(纵向扩容)。当系统容量不足时,可以增加组来扩充存储容量(横向扩容)

Storage server会连接集群中所有的Tracker server,定时向他们报告自己的状态,包括磁盘剩余空间、文件同步状况、文件上传下载次数等统计信息。

3、fastdfs的上传过程

FastDFS向使用者提供基本文件访问接口,比如upload、download、append、delete等,以客户端库的方式提供给用户使用。

Storage Server会定期的向Tracker Server发送自己的存储信息。当Tracker Server Cluster中的Tracker Server不止一个时,各个Tracker之间的关系是对等的,所以客户端上传时可以选择任意一个Tracker。

当Tracker收到客户端上传文件的请求时,会为该文件分配一个可以存储文件的group,当选定了group后就要决定给客户端分配group中的哪一个storage server。当分配好storage server后,客户端向storage发送写文件请求,storage将会为文件分配一个数据存储目录。然后为文件分配一个fileid,最后根据以上的信息生成文件名存储文件。

客户端上传文件后存储服务器将文件ID返回给客户端,此文件ID用于以后访问该文件的索引信息。文件索引信息包括:组名,虚拟磁盘路径,数据两级目录,文件名。 例如:group1/M00/02/44/abcdefgh.sh

- 组名:文件上传后所在的storage组名称,在文件上传成功后有storage服务器返回,需要客户端自行保存。

- 虚拟磁盘路径:storage配置的虚拟路径,与磁盘选项store_path*对应。如果配置了store_path0则是M00,如果配置了store_path1则是M01,以此类推。

- 数据两级目录:storage服务器在每个虚拟磁盘路径下创建的两级目录,用于存储数据文件。

- 文件名:与文件上传时不同。是由存储服务器根据特定信息生成,文件名包含:源存储服务器IP地址、文件创建时间戳、文件大小、随机数和文件拓展名等信息。

4、FastDFS的文件同步

写文件时,客户端将文件写至group内一个storage server即认为写文件成功,storage server写完文件后,会由后台线程将文件同步至同group内其他的storage server。

每个storage写文件后,同时会写一份binlog,binlog里不包含文件数据,只包含文件名等元信息,这份binlog用于后台同步,storage会记录向group内其他storage同步的进度,以便重启后能接上次的进度继续同步;进度以时间戳的方式进行记录,所以最好能保证集群内所有server的时钟保持同步。

storage的同步进度会作为元数据的一部分汇报到tracker上,tracke在选择读storage的时候会以同步进度作为参考。

5、FastDFS的文件下载

客户端uploadfile成功后,会拿到一个storage生成的文件名,接下来客户端根据这个文件名即可访问到该文件。

跟upload file一样,在downloadfile时客户端可以选择任意tracker server, client发送download请求给某个tracker,必须带上文件名信息,tracke从文件名中解析出文件的group、大小、创建时间等信息,然后为该请求选择一个storage用来服务读请求

三、安装部署(单机版)

1、环境准备:

系统: centos7

2、安装GCC环境和Perl,执行命令如下:

yum install git gcc gcc-c++ make automake autoconf libtool pcre pcre-devel zlib zlib-devel openssl-devel wget vim -y

3、安装libevent:

FastDFS依赖libevent库,需要安装,执行命令如下:

yum -y install libevent

4、安装libfastcommon:

libfastcommon是FastDFS官方提供的,libfastcommon包含了FastDFS运行所需要的一些基础库, 下载地址: https://github.com/happyfish100/libfastcommon/releases 选择合适的版本 ,也可以通过

git clone https://github.com/happyfish100/libfastcommon.git --depth 1下载

#创建目录,并进入到目录中

mkdir /usr/local/fastdfs && cd /usr/local/fastfds

#进入到自定义目录中,将安装包上传到机器中

rz -y libfastcommon-1.0.52.tar.gz

#将安装包进行解压缩

tar xf libfastcommon-1.0.52.tar.gz

#进入解压后的目录

cd libfastcommon-1.0.52

#执行命令进行编译和安装

./make.sh

./make.sh install5、安装FastDFS:

下载地址:https://github.com/happyfish100/fastdfs/releases 选择合适的版本 ,也可以通过

git clone https://github.com/happyfish100/fastdfs.git --depth 1下载

#进入目录中

cd /usr/local/fastdfs

#将安装包上传到目录中并解压

rz -y fastdfs-6.07.tar.gz

#进入到解压后的目录中

cd fastdfs-6.07

#执行命令进行编译和安装

./make.sh

.make.sh install

#注意:如果编译出错误可以先执行./make.sh clean 清除,然后重新执行./make.sh即可安装完成后,在/etc/init.d/中可以看到跟踪器和存储器的可执行文件,如图:

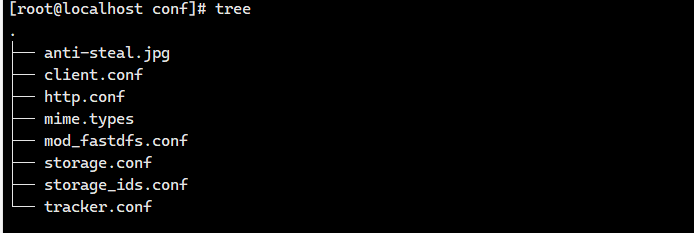

配置文件准备:

#配置文件准备

cp /etc/fdfs/tracker.conf.sample /etc/fdfs/tracker.conf

cp /etc/fdfs/storage.conf.sample /etc/fdfs/storage.conf

cp /etc/fdfs/client.conf.sample /etc/fdfs/client.conf #客户端文件,测试用

cp /usr/local/fastdfs/fastdfs-6.07/conf/http.conf /etc/fdfs/ #供nginx访问使用

cp /usr/local/fastdfs/fastdfs-6.07/conf/mime.types /etc/fdfs/ #供nginx访问使用配置文件在路径/etc/fdfs目录下,mod_fastdfs.conf是后续模块会用的,如图:

命令工具在 /usr/bin/ 目录下:

fdfs_appender_test

fdfs_appender_test1

fdfs_append_file

fdfs_crc32

fdfs_delete_file

fdfs_download_file

fdfs_file_info

fdfs_monitor

fdfs_storaged

fdfs_test

fdfs_test1

fdfs_trackerd

fdfs_upload_appender

fdfs_upload_file

stop.sh

restart.sh6、配置FastDFS跟踪器(Tracker):

进入 /etc/fdfs,复制 FastDFS 跟踪器样例配置文件 tracker.conf.sample,并重命名为 tracker.conf,编辑tracker.conf,修改内容如下:

# 配置文件是否不生效,false 为生效

disabled=false

# 提供服务的端口

port=22122

# Tracker 数据和日志目录地址(根目录必须存在,子目录会自动创建)

base_path=/data/fastdfs/tracker

# HTTP 服务端口 默认8080 ,建议修改 防止冲突

http.server_port=9080创建tracker基础数据目录,即base_path对应的目录:

mkdir -p /data/fastdfs/tracker启动tracker:

/etc/init.d/fdfs_trackerd start

或者

/usr/bin/fdfs_trackerd /etc/fdfs/tracker.conf

#添加到开机自启动文件中

echo "/etc/init.d/fdfs_trackerd start" >> /etc/rc.d/rc.local

#给rc.local赋予可执行权限

chmod +x /etc/rc.d/rc.local

#关闭命令

/etc/init.d/fdfs_tracked stop执行命令/etc/init.d/fdfs_tracked status查看状态,如下:

[root@localhost fdfs]# /etc/init.d/fdfs_trackerd status

● fdfs_trackerd.service - LSB: FastDFS tracker server

Loaded: loaded (/etc/rc.d/init.d/fdfs_trackerd; bad; vendor preset: disabled)

Active: active (running) since Sat 2021-10-23 03:56:51 EDT; 2min 40s ago

Docs: man:systemd-sysv-generator(8)

Process: 13348 ExecStart=/etc/rc.d/init.d/fdfs_trackerd start (code=exited, status=0/SUCCESS)

CGroup: /system.slice/fdfs_trackerd.service

└─13353 /usr/bin/fdfs_trackerd /etc/fdfs/tracker.conf

Oct 23 03:56:51 localhost.localdomain systemd[1]: Starting LSB: FastDFS tracker server...

Oct 23 03:56:51 localhost.localdomain fdfs_trackerd[13348]: Starting FastDFS tracker server:

Oct 23 03:56:51 localhost.localdomain systemd[1]: Started LSB: FastDFS tracker server.

Tracker服务启动成功后,会在base_path下创建data、logs两个目录

注意:tracker 不去主动读取storage的相关信息,而是由storage主动推送给tracker,因此必须先启动tracker

7、配置 FastDFS 存储 (Storage)

进入 /etc/fdfs 目录,复制 FastDFS 存储器样例配置文件 storage.conf.sample,并重命名为 storage.conf,编辑storage.conf文件,主要修改位置如下:

# Storage 数据和日志目录地址(根目录必须存在,子目录会自动生成) (注 :这里不是上传的文件存放的地址,之前版本是的,在某个版本后更改了)

base_path=/data/fastdfs/datalog

# 如果不配置 store_path0,那它就和 base_path 对应的路径一样,这个路径才是真正储存文件的地方

store_path0=/data/fastdfs/storage0

# tracker_server 的列表 ,会主动连接 tracker_server

# 有多个 tracker server 时,每个 tracker server 写一行

tracker_server=192.168.0.200:22122

tracker_server=192.168.0.201:22122

#http_server_port,默认为8888,后续需要和nginx端口保持一致

http.server_port = 8888创建Storage数据目录,对应相应目录:

#对应base_path

[root@localhost ~]# mkdir -p /data/fastdfs/datalog

#对应store_path0的路径

[root@localhost ~]# mkdir -p /data/fastdfs/storage0启动storage,执行命令/etc/init.d/fdfs_storage start ,如下:

#执行如下命令启动:

[root@localhost ~]# /etc/init.d/fdfs_storaged start

Starting fdfs_storaged (via systemctl): [ OK ]

或者

/usr/bin/fdfs_storaged /etc/fdfs/storage.conf

#添加到开机自启动文件中

echo "/etc/init.d/fdfs_storaged start" >> /etc/rc.d/rc.local查看运行状态如下:

[root@localhost init.d]# /etc/init.d/fdfs_storaged status

● fdfs_storaged.service - LSB: FastDFS storage server

Loaded: loaded (/etc/rc.d/init.d/fdfs_storaged; bad; vendor preset: disabled)

Active: active (running) since Sat 2021-10-23 04:46:43 EDT; 47s ago

Docs: man:systemd-sysv-generator(8)

Process: 13899 ExecStart=/etc/rc.d/init.d/fdfs_storaged start (code=exited, status=0/SUCCESS)

CGroup: /system.slice/fdfs_storaged.service

└─13904 /usr/bin/fdfs_storaged /etc/fdfs/storage.conf

Oct 23 04:46:43 localhost.localdomain systemd[1]: Starting LSB: FastDFS storage server...

Oct 23 04:46:43 localhost.localdomain fdfs_storaged[13899]: Starting FastDFS storage server:

Oct 23 04:46:43 localhost.localdomain systemd[1]: Started LSB: FastDFS storage server.

#监听23000端口

注意:启动Storage前确保Tracker是启动的。初次启动成功,会在 /data/fastdfs/storage(base_path) 目录下创建 data、 logs 两个目录,记录着 Storage Server 的信息。在 store_path0/data 目录下,创建了N*N个子目录:查看Storage和Tracker是否在通信:

[root@localhost data]# /usr/bin/fdfs_monitor /etc/fdfs/storage.conf

[2021-10-23 04:52:15] DEBUG - base_path=/data/fastdfs/storage, connect_timeout=5, network_timeout=60, tracker_server_count=1, anti_steal_token=0, anti_steal_secret_key length=0, use_connection_pool=1, g_connection_pool_max_idle_time=3600s, use_storage_id=0, storage server id count: 0

server_count=1, server_index=0

tracker server is 192.168.203.128:22122

group count: 1

Group 1:

group name = group1

disk total space = 17,394 MB

disk free space = 15,663 MB

trunk free space = 0 MB

storage server count = 1

active server count = 1

storage server port = 23000

storage HTTP port = 8888

store path count = 1

subdir count per path = 256

current write server index = 0

current trunk file id = 0

Storage 1:

id = 192.168.203.128

ip_addr = 192.168.203.128 ACTIVE

http domain =

version = 6.07

join time = 2021-10-23 04:40:30

8、配置客户端文件(client.conf):

将client.conf.sample修改为client.conf,编辑client.conf,修改内容如下:

#client的数据和日志目录

base_path = /data/fastdfs/client

#tracker的服务和端口

tracker_server = 192.168.203.128:22122创建数据和日志目录:

mkdir -p /data/fastdfs/client9、测试上传

创建文件并上传,如下:

echo "hello world fastdfs" > fdfs.txt #定义文件

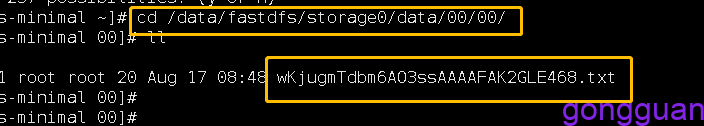

[root@centos-minimal ~]# /usr/bin/fdfs_upload_file /etc/fdfs/client.conf fdfs.txt

group1/M00/00/00/wKjugmTdbm6AO3ssAAAAFAK2GLE468.txt

上传成功后,可以找到文件位置在/data/fastdfs/storage0/data/00/00路径下,如图:

注意:如果不安装fastdfs-nginx-module,直接通过ip:8888/group1/……也可以访问文件

10、 安装配置fastdfs-nginx-module模块(多节点的fdfs一定要用此模块):

FastDFS 通过 Tracker 服务器,将文件放在 Storage 服务器存储, 但是同组存储服务器之间需要进行文件复制, 有同步延迟的问题。

假设 Tracker 服务器将文件上传到了 192.168.51.128,上传成功后文件 ID已经返回给客户端, 此时 FastDFS 存储集群机制会将这个文件同步到同组存储 192.168.51.129,在文件还没有复制完成的情况下,客户端如果用这个文件 ID 在 192.168.51.129 上取文件,就会出现文件无法访问的错误, 而 fastdfs-nginx-module 可以重定向文件链接到源服务器取文件,避免客户端由于复制延迟导致的文件无法访问错误。

#首先将fastdfs-nginx-module-1.22.tar.gz上传到机器上

cd /usr/local/fastdfs

rz -y fastdfs-nginx-module-1.22.tar.gz

tar xf fastdfs-nginx-module-1.22.tar.gz

cd fastdfs-nginx-module-1.22/src

#复制其中的mod_fastdfs.conf文件到/etc/fdfs下

cp mod_fastdfs.conf /etc/fdfs

#编辑mod_fastdfs.conf,修改内容如下:

tracker_server=192.168.203.128:22122 #tracker服务器IP和端口

url_have_group_name=true #启用url路径使用组名

store_path0=/data/fastdfs/file #修改文件保存的路径,路径必须和storage.conf中配置的相同注:要先安装完libfastcommon和fastdfs后再安装fastdfs-nginx-module才行,否则报错

10、安装Nginx:

#安装nginx,可根据需要选择yum或者二进制安装

yum -y install pcre* zlib* #安装依赖包

wget http://nginx.org/download/nginx-1.20.0.tar.gz

tar xf nginx-1.20.0.tar.gz

cd nginx-1.20.0

#添加fastdfs-nginx-module模块

./configure --prefix=/usr/local/nginx --add-module=/usr/local/fastdfs/fastdfs-nginx-module-1.22/src/

#编译安装

make && make install

#关闭selinux

sed -i "s/SELINUX=enforcing/SELINUX=disabled/g" /etc/selinux/config编辑配置文件,添加内容如下:

如果不通过fastdfs_module_nginx模块,也可以 通过如下方式配置

注意:alias后面的地址就是实际文件存储的地址,也就是storage.conf中配合的store_path0的地址

重新加载Nginx配置或者重启,然后通过浏览器访问试试,如图:

#浏览器访问地址如下:

http://192.168.203.128/group1/M00/00/00/wKjLgGFzz9eAJ3MFAAZbu1dcGUk255.png

注意:如果访问日志提示权限问题,无法访问,此时可以查看selinux是否关闭

如果通过命令行访问或者下载(tcp方式),需要执行命令:

/usr/bin/fdfs_test /etc/fdfs/client.conf download group1 M00/00/00/CgkCHWF484GAQtHLAADvBAE2ew0883.png 注意:group1和后面之间有空格注:fdfs_tracckerd和fdfs_storaged不是一定部署在同一台机器上,可根据需要部署在不同机器

四、安装部署(集群版)

注意:如果fdfs是集群模式,那么必须使用 fastdfs-nginx-module模块

本例子中的机器数量为3台

1、安装libfastcommon(三台机器都需要安装)

2、安装FastDFS(三台机器都需要安装)

tracker.conf: 参考上面的配置修改即可,三台机器都要修改

storage.conf: 参考上面的配置修改即可,tracker_server的地址需要写三台机器的地址,三台机器都要修改

client.conf:参考上面配置修改即可,tracker_server 写三台机器地址

mod_fastdfs.conf:tracker_server地址修改为三台机器地址,其余参照上面修改

nginx的配置也参考上面即可

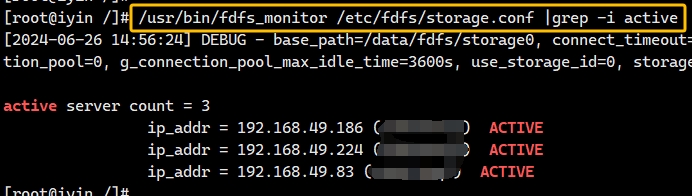

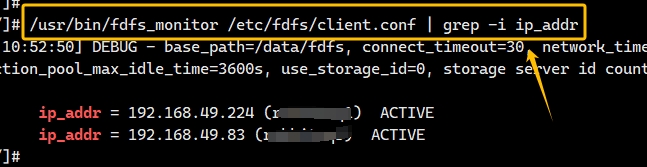

检测集群:

/usr/bin/fdfs_monitor /etc/fdfs/storage.conf

# 会显示会有几台服务器 有3台就会 显示 Storage 1-Storage 3的详细信息下图表示查看的集群三台机器都是正常状态,显示为ACTIVE,如图:

注:配置为集群后,在其中一个节点上传文件将会自动同步到其他节点

五、目录结构

1、首先查看配置文件目录下conf下文件,如图:

- client.conf:客户端配置文件,这里也要修改

- mime.types:定义文件扩展名和对应的MIME类型的配置文件

- mod_fastdfs.conf:ngx_fastdfs_module模块使用

- storage.conf:存储配置

- storage_ids.conf:修改storage标识从IP改为id

- tracker.conf:跟踪配置

2、storage0目录结构如下:

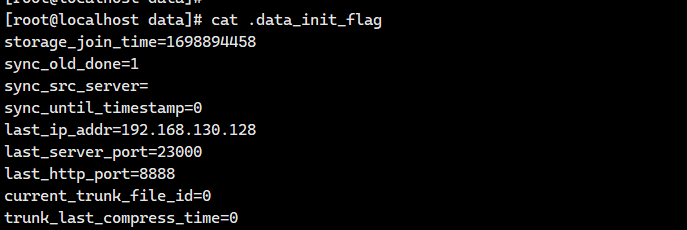

- .data_init_flag:当前storage server初始化信息,此文件为隐藏文件

- storage_stat.dat:当前storage server统计信息

- sync:存放数据同步的相关文件,其中binlog.index:当前的binlog(更新操作日志)文件索引号,binlog.###:存放更新操作记录(日志),${ip_addr}_${port}.mark:存放向目标服务器同步的完成情况

- 一级目录:256个存放数据的目录,目录名为十六进制字符,如:00,1F等,在一级目录下还有二级目录,也是十六进制字符

- storaged.log:storage的运行日志

.data_init_flag文件为ini配置文件方式,主要参数如下:

- storage_join_time:本机storage server创建时间

- sync_old_done:本机storage是否已完成同步的标志(源服务器向本服务器同步已有数据)

- sync_src_server:向本服务器同步已有数据的源服务器IP地址,没有则为空

- sync_until_timestamp:同步已有数据文件截至时间(UNIX时间戳)

storage_stat.dat文件也是格式为ini的方式,主要参数如下:

- total_upload_count: 上传文件次数

- success_upload_count: 成功上传文件次数

- success_delete_count: 成功删除文件次数

- total_download_count: 下载文件次数

- success_download_count: 成功下载文件次数

- total_delete_count: 删除文件次数

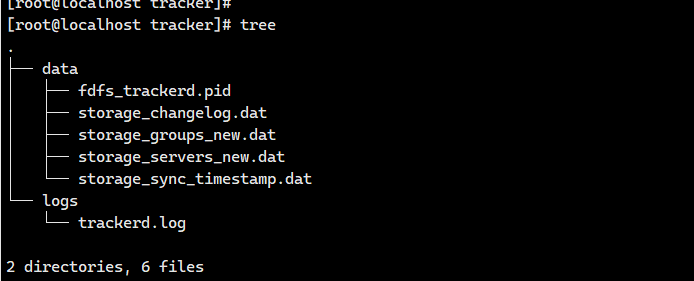

3、tracker目录结构如下:

- storage_groups_new.dat: 存储的分组信息

- storage_servers_new.dat: 存储服务器列表

- storage_sync_timestamp.dat:同步时间戳

- storage_changelog.dat: 修改记录

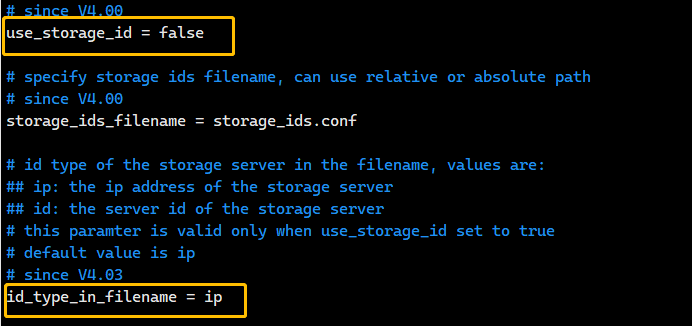

附加:上述安装方式为默认以ip作为标识storage的方式安装,可以查看tracker.conf,如图:

默认情况下user_storage_id为false,id_type_in_filename为ip,也就是通过IP来标识storage,但是这种情况下2个问题,第一个问题是迁移后需要修改的配置较多,第二个问题是如果想将IP标识修改为id标识,可能启动后会报错重复IP,如下:

ERROR - file: tracker_mem.c, line: 1196, in the file "/data/fdfs/tracker/data/storage_servers_new.dat", storage "192.168.130.128" is duplicate如果报此错误,可将storage0/data和tracker/data目录下文件全部清空并重启fdfs即可

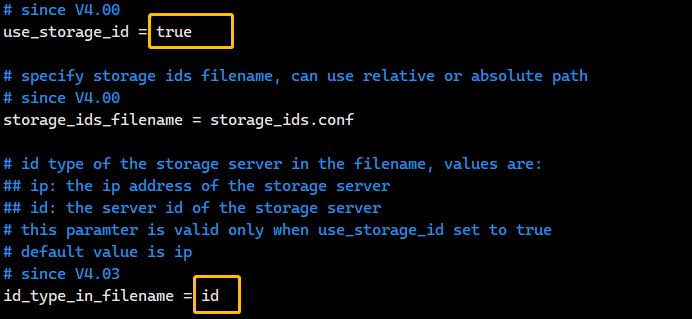

因此,如果为了以后迁移方便,建议安装的时候选择自定义server id 的方式来识别storage,只需要修改两个地方,方法如下:

1、修改tracker.conf 文件,如图:

将user_storage_id设置为true后,storage_ids.conf才会生效

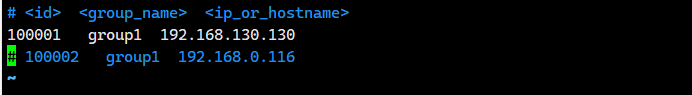

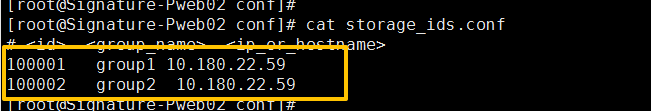

2、修改storage_ids.conf文件,如图:

- id:可自定义

- group1:要与stroage.conf中保持一致

- IP:本机IP

本机如果还有group2,就需要在添加一行,比如:1000002 group ip ,如图:

注意:如果group1能启动,但是group2无法启动就需要检查是不是storage_ids.conf中配置有问题了

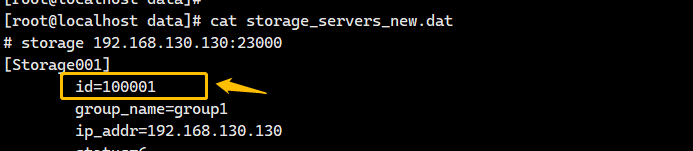

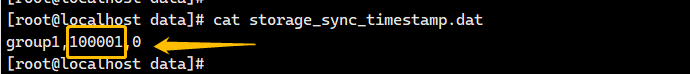

3、启动fastdfs后,进入tracker/data路径可以看到storage_servers_new.data和storage_sync_timestamp.dat中有id信息,如图:

注:如果是IP方式标识stroage,第一个图中没有id,第二个图中标记的位置为IP

六、集群节点增加与删除

注:本例子演示的为storaged和trackerd都运行在同一台机器上

增加

增加节点很简单,新部署一个节点,然后修改新节点与老节点中配置文件的tracker_server、group名,存储位置,尽量与老节点保持一致,然后启动即可

删除

以上面的集群为例,现在要删除集群中的49.186节点,主要部署如下

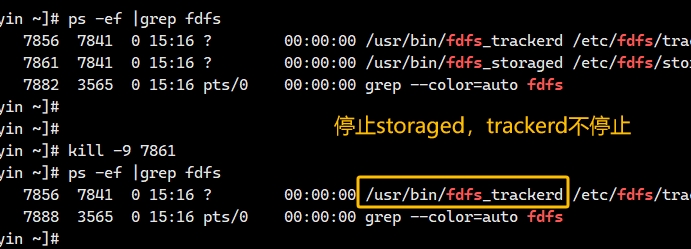

1、首先停止掉49.186机器的storaged,trackerd不能停止,如图:

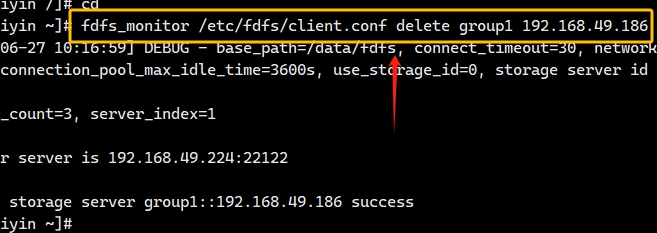

2、在其他任意其中一个节点上执行命令删除49.186上的storaged,如图:

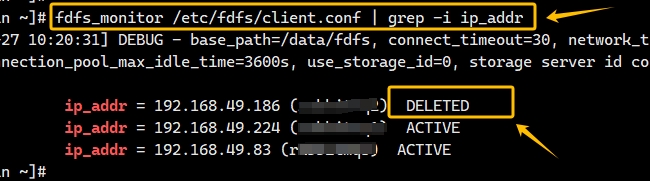

再次查看,已经删除,如图:

如果要重新加入,只需要将49.186上的stroaged启动即可

3、删除集群中49.186上的tracker,首先将49.186上的tracker停止,然后在其他节点配置文件中将tracker_server注释掉即可,删除后重启其余两个节点的fastdfs,此时发现tracker启动报错:

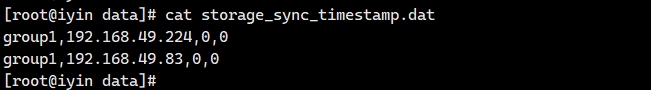

ERROR - file: tracker_mem.c, line: 1535, the format of the file "/data/fdfs/tracker/data/storage_sync_timestamp.dat" is invalid, group_name: group1, colums: 5 > 4

因为49.186已经不用了,因此可将其删除,但是删除后还是起不来,此时将每个IP后一个,0删除,保留2个即可,如图:

最后重启即可,查看此时集群状态,如图:

为什么将storage_sync_timestamp.dat中49.186行删除掉,并将其他两行的最后一个,0删除,就可以启动了?

个人理解:第一个0表示同步偏移量,第二个0表示同步时间戳,因为有三个节点,每个节点都需要与其余两个节点同步,因此每个节点就会存在两个同步时间戳,如果只有两个节点,那么每个节点只需要与另一个节点同步即可,此时就需要一个同步时间戳

其他常见问题

1、storage的日志提示如下内容:

ERROR - file: storage_sync.c, line: 254, fdfs_recv_response fail, result: 17状态码17的意思是文件已经存在,如果集群之间互相同步就会返回状态码17,可以忽略此错误

2、storage如何重新向其他节点同步数据?

storage路径data/sync路径下的*.mark文件,其中的binlog_offset 表示当前 binlog 文件的偏移量,用于记录同步操作的进度。当 FastDFS 的 Storage 节点进行文件同步时,会根据 binlog_offset 从 binlog 文件中读取未同步的记录,并将其同步到目标节点,通过修改 binlog_offset,可以跳过已经同步的部分,直接从上次同步的中断点开始继续同步。这可以避免重复同步已经处理过的记录,从而提高同步效率,如果出现同步中断或异常,手动调整 binlog_offset 可以帮助恢复同步。例如,当同步过程中出现错误或中断时,将 binlog_offset 设置为 0,可以让 FastDFS 从头开始重新同步文件

3、如何观察当前集群是否还在正常互相同步数据?

查看storage/data/sync/binlog.index文件,看下当前的索引文件是哪个,比如是binlog.013,然后查看这个文件中正在同步的文件名,在集群中的所有节点查看是否存在这个文件,如果都存在,并且binlog.013中还在不断更新同步的文件,说明此时集群状态是正常的